Hogyan ismerjünk fel egy deepfake csalást?

Ha nem vagyunk biztosak benne, hogy valóban azzal folytatunk videóbeszélgetést, akivel gondoljuk, a deepfake szoftverek gyengeségei segíthetnek felismerni a csalást.

Korábbi bejegyzésünkben már bemutattuk a deepfake videókat – azt a technológiát, amelynek segítségével a csalók fel tudják venni egy másik ember arcát egy videóbeszélgetésben. Nemrég ezzel a trükkel vertek át több európai polgármestert, közöttük Karácsony Gergelyt.

Szerencsére van egy egyszerű trükk, amelynek segítségével fel lehet ismerni a hamisított videók többségét: meg kell kérni a beszélgetőpartnert, hogy fordítsa el az arcát oldalra, és maradjon úgy 2 másodpercig.

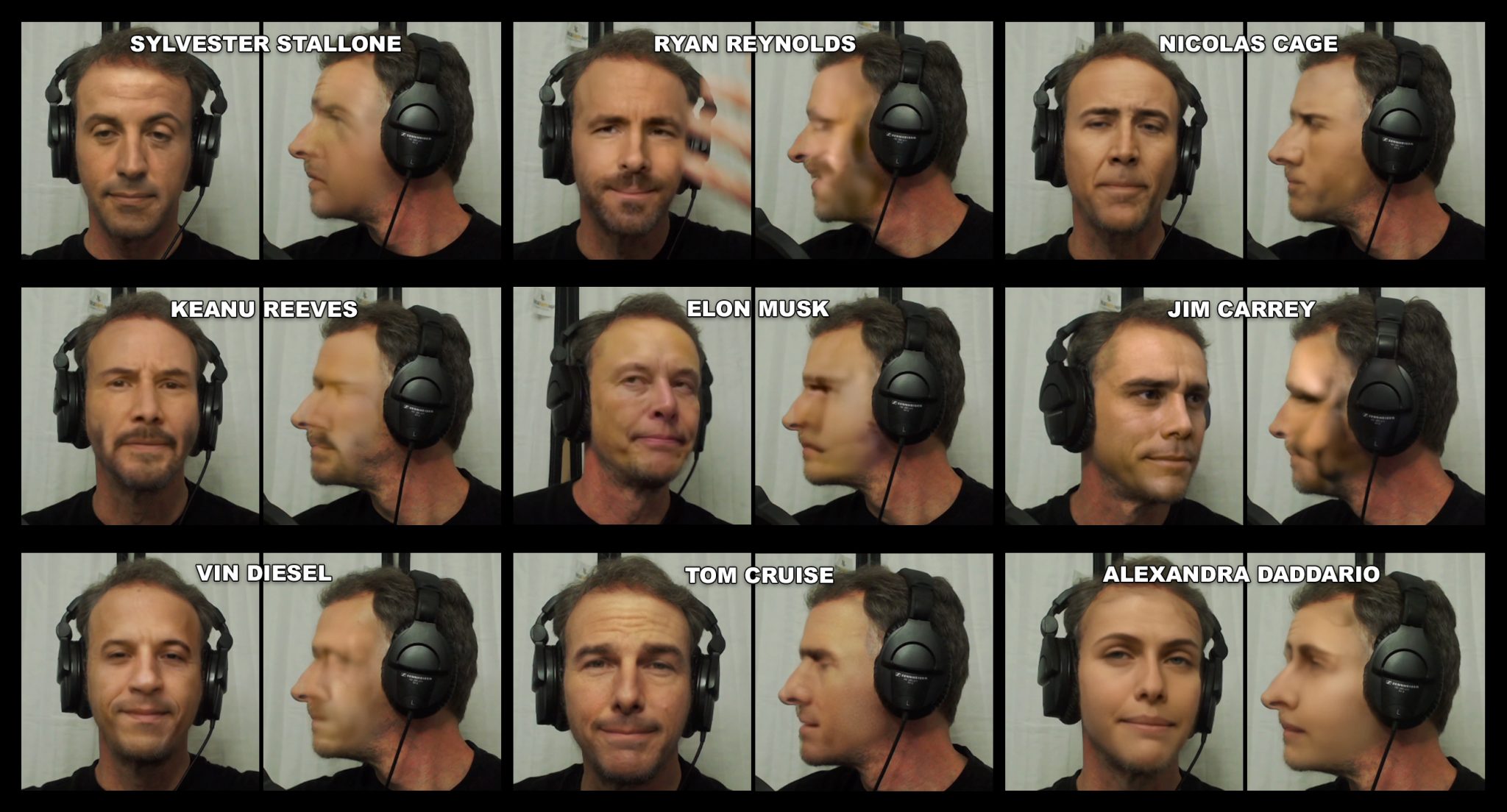

A trükköt a kifejezetten ilyen videókra szakosodott Metaphysic nevű cég osztotta meg, egy kis magyarázat kíséretében. A deepfake programok általában nem túl jók abban, hogy profilból is képesek legyenek lecserélni az emberek arcát, a hiba pedig azonnal kiütközik, amint valaki 90 fokban elfordítja a fejét.

Ennek az egyik oka, hogy a deepfake szoftverek azonosítópontokkal dolgoznak, és amikor egy arc profilból látszik, akkor ezeknek az azonosítási pontoknak csak a fele áll rendelkezésre.

A másik ok gyakorlatiasabb: általában jóval kevesebb profilkép áll rendelkezésre mindenkiről. A politikusok, színészek, de a hétköznapi emberek is sokkal ritkábban osztanak meg profilképet (és videókat) magukról, hiszen általában szemből előnyösebb benyomást tudunk kelteni, és az a megszokott, hogy szemtől-szembe kommunikálunk másokkal. Ezért ha valakinek a profilját is modellezni szeretnék a csalók, akkor lényegesen több mintára van szükségük, és a modellezéshez szükséges idő is jelentősen növekszik.

A jelenség illusztrálására a Metaphysic szakértője, Martin Anderson két képet tett közzé:

Ugyanakkor ha a hackerek mégis elegendő mintát szereznek a profilképek megalkotásához és a modellkészítésre is időt fordítanak, még mindig van egy lehetőségünk.

A deepfake programok ma még nem igazán tudják kezelni, ha valami a hamisított beszélgetőpartner arca elé kerül. Ezért ha megkérjük a videóbeszélgetésben résztvevő partnert, hogy integessen az arca előtt, vagy egy lapot mozgasson az arca előtt, akkor a deepfake hamisítás leleplezhető.

A Metaphysic szakértőjének eredeti blogbejegyzése itt olvasható.